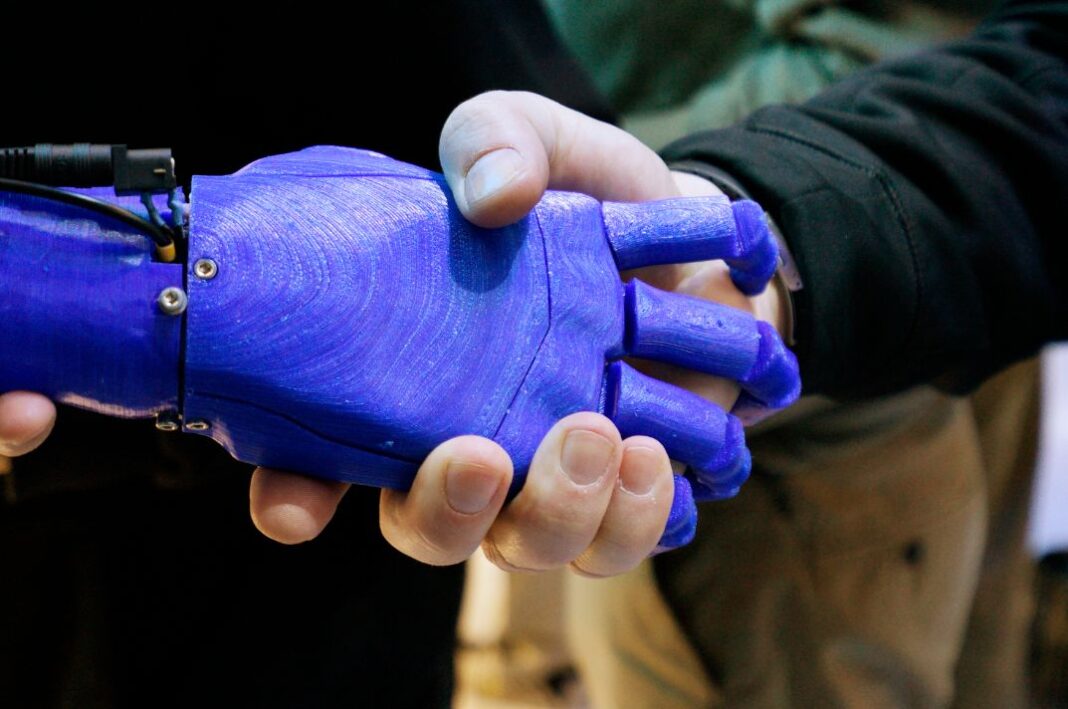

Molti ricercatori vedono nel progresso della robotica una maniera per raffinare le IA, che dotandosi di un corpo, potrebbero percepire e agire e così costruirsi un modello di causalità e imparare a stare al mondo

L’Intelligenza Artificiale (IA) si distingue in due tipi: ristretta (IAR) e generale (IAG). La IAR è progettata per compiti molto specifici e segue regole definite previamente da un programmatore umano. Ciò le garantisce prestazioni impressionanti in domini specifici, come la visione artificiale, ma non potendo apprendere autonomamente nuove regole d’azione, fallisce al cambio del contesto.

La IAG, invece, è progettata per compiti generali e si ispira alla cognizione umana e animale. Una IAG potrebbe apprendere nuove regole per risolvere problemi, prendere decisioni e usare il linguaggio naturale. Tuttavia, una IAG simil-umana ancora non esiste, ma ChatGPT di OpenAI è un noto tentativo di raggiungerla. Può l’IA stare al mondo in maniera autonoma come farebbe un qualsiasi essere vivente prima ancora dell’uomo? Rispondere a questo interrogativo è essenziale se vogliamo che un giorno le IA guidino le nostre auto, riscattino la nostra gente dalle macerie di un terremoto o esplorino lo spazio alla ricerca di pianeti abitabili.

Scoprire la regola

Le IA quasi-generali (IAqG) usano reti neurali e apprendimento profondo per generare nuovi contenuti. Ne è un chiaro esempio ChatGPT e le sue straordinarie capacità di colloquiare con utenti umani. Ma da dove vengono queste capacità? Anche per i creatori il processo è parzialmente oscuro, ma la rete neurale di ChatGPT è stata in grado di riconoscere delle regole, o costanti, tipiche del linguaggio umano, grazie all’apprendimento profondo su una vastissima quantità di dati.

Se l’IAqG vuole emulare la cognizione umana, allora è bene vedere come gli animali scoprono le regole e il caso dell’uomo. Immaginiamo una giraffa che dopo essersi alimentata del fogliame di un albero si senta male di stomaco. Mostrarsi debilitati potrebbe attrarre le attenzioni di un predatore nei paraggi e quindi mettere a rischio la vita. Ciò spinge la giraffa a non alimentarsi mai più da quella specie di albero e da alberi simili. La giraffa ha cioè generalizzato un’esperienza altrimenti puntuale e ha scoperto una regola d’azione che potrebbe favorirne sopravvivenza e riproduzione. Ciò serve agli animali per stare al mondo. Diversamente dagli animali, a una IAqG non basterebbe mai una sola esposizione a un dato oggetto per generare una regola d’azione adatta, da qui la necessità di apprendimento profondo su una vastissima quantità di dati.

Noi umani, inoltre, eccelliamo nello scoprire regole grazie al ragionamento induttivo, che ci consente anche di immaginarci la prossima mossa di un attore geopolitico o di fare scienza. Diversamente dal ragionamento deduttivo, dove una regola generale nota viene applicata logicamente a un caso particolare, similmente a una IAR, il ragionamento induttivo ci permette di generalizzare o riconoscere una regola all’interno di un contesto a partire da un numero finito di eventi osservati. Per esempio, se entrando in diverse case, ogni volta ci accorgiamo di calpestare un pavimento, potremmo indurre la regola che “tutte le case hanno un pavimento”, anche non entrando in tutte le case del mondo. È possibile testare questo tipo di ragionamento con ChatGPT chiedendogli di completare una sequenza, senza però dichiararne la regola di completamento, e notare come fallisce anche con regole banali. L’utilizzo di questa abilità deve aver permesso all’uomo di arrivare fin dov’è oggi e di persistere nel mondo, un posto dove una IAgG, date le premesse, non durerebbe a lungo.

Apprendere

È allora nella maniera di apprendere che esiste uno scarto fra intelligenze biologiche a IA. Abbiamo già accennato che per effettuare algoritmi di apprendimento profondo è richiesta una vastissima quantità di dati. Sì, ma quanto vasta? Quant’è ancora lo scarto fra cervello animale e IAqG? Danko Nikolić, esperto di mente e cervello e direttore generale della compagnia di IA Robots Go Mental, ha analizzato recentemente il problema. Egli nota come per poter aumentare la loro intelligenza, cioè questa capacità di compiere generalizzazioni, i sistemi di apprendimento profondo richiedano un eccessivo aumento di risorse, descrivibile da una legge di potenza. Ciò significa che, per esempio, per raddoppiare il numero di oggetti riconosciuti da una rete neurale specializzata in visione artificiale, il numero di risorse richieste aumenterebbe di 500 volte. Per modelli di linguaggio naturale, il costo è ancora più alto: un aumento di dati di quasi 8000 volte. Oggi, gli oggetti visivi distinguibili accuratamente da una IA allo stato dell’arte sono circa un migliaio (103). A differenza di una IA, un cervello biologico può riconoscere accuratamente e senza sforzo nuovi arrangiamenti di oggetti mai visti prima. Si stima che l’uomo possa percepire accuratamente fino ai 1064 nuovi arrangiamenti di oggetti visivi, e senza dover ricorrere all’apprendimento. Come? Noi possiamo ri-arrangiare le nostre conoscenze pregresse in nuove combinazioni, mentre le IA falliscono in questo. E quando ricorriamo invece all’apprendimento di fatti o abilità genuinamente nuovi, non seguiamo una legge di potenza, bensì apprendiamo in maniera lineare: cioè conoscenze o abilità aumentano linearmente con il tempo dedicato al loro apprendimento. Per dare una dimostrazione delle nostre abilità nel ri-arrangiare conoscenze pregresse, avete mai letto la frase “una giraffa sedeva sul fondo dell’oceano”? Eppure, non fate fatica a comprenderla.

Comprendere

Cosa significa comprendere? Le IA comprendono quando rispondono in maniera impeccabile alle nostre domande? Questo è il quesito posto da Melanie Mitchell e David Krakauer a vari esperti di IA. Esperti di formazione psicologica sostengono che le IA non potranno mai comprendere. Si prenda ad esempio la parola “solletico”. Nonostante una IA come ChatGPT possa manipolare il vocabolo come simbolo, cioè utilizzarlo per collocarlo in frasi nuove e dotate di coerenza impeccabile, non saprà mai quale è il suo significato non possedendo un corpo per poterlo provare. Altri pensano che questi modelli di linguaggio naturale, invece, già possano comprendere in senso umano. Infatti, essi catturerebbero aspetti importanti del significato, per esempio, discernendo se una stessa parola cambi significato al cambiare del contesto. Un’ultima frazione di esperti, ancora, propone che queste IA possano sì comprendere, ma in un altro senso: la loro e la nostra sarebbero due tipologie di comprensione diverse. Così, gli strumenti che usiamo per valutare la comprensione umana potrebbero non essere adatti per giudicare una IA. Tuttavia, uomo e macchina potrebbero spartirsi i ruoli in futuro: problemi richiedenti vastissima quantità di conoscenza codificata storicamente favoriranno la prestazione di modelli statistici a larga scala di linguaggio; mentre problemi per cui abbiamo conoscenze ancora molto limitate, ma potenzialmente spiegabili da meccanismi causali, favoriranno l’intelligenza umana.

Causalità e corporeità

Entra così in gioco il ruolo della causalità. Dicevamo che l’apprendimento profondo è ciò che permette a una IAqG l’ottenimento di prestazioni così sorprendenti. Tuttavia, è proprio tale modalità di apprendimento a pregiudicarne la capacità di stare al mondo. Infatti, queste IA hanno un problema grosso: gli eventi rari. Essi, infatti, essendo poco frequenti per definizione, sono sottorappresentati nell’insieme di dati forniti in pasto all’apprendimento profondo; pertanto, non contribuiscono alla struttura della rete neurale.

Questo porterebbe sicuramente degli svantaggi a una IA mandata nello spazio a colonizzare un nuovo pianeta, un’avventura nella quale è molto difficile sapere cosa aspettarsi e l’imprevisto potrebbe essere dietro l’angolo. Inoltre, qualora una IAqG apprendesse come condurre un’auto in Italia, se fosse messa in strada in Inghilterra, dove la guida è invertita, non riuscirebbe a guidare senza ricorrere a un estensivo ri-apprendimento, solo possibile attraverso la perdita delle conoscenze pregresse. Un uomo messo nelle stesse condizioni non tarderebbe troppo ad abituarsi al nuovo stile di guida e, tornato in Italia, saprebbe ancora portare i figli a scuola.

Per risolvere questi problemi, i ricercatori vorrebbero dotare le IA della possibilità di operare con la legge di causalità. Ciò renderebbe innecessario l’apprendimento di così tante correlazioni fra variabili e garantirebbe adattabilità anche in contesti cangianti. Tale apprendimento sarebbe basato sull’applicare cambi a qualcosa e valutare cosa accade a questo qualcosa. Probabilmente ciò è molto simile a come gli animali imparano a stare al mondo da quando sono piccoli. Per esempio, un bambino potrebbe capire che lasciar cadere un giocattolo al suolo farà rumore, o anche che non sarà così forte se a cadere fosse un cuscino. Così, molti ricercatori vedono nel progresso della robotica una maniera per raffinare le IA, che dotandosi di un corpo, potrebbero percepire e agire nel mondo e così costruirsi un modello di causalità. Tali raggiungimenti sarebbero possibili attraverso una stretta collaborazione tra neuroscienze sensoriomotorie, robotica e IA, in un programma di ricerca recentemente auspicato dai maggiori neuroscienziati del campo e nominato NeuroAI. Tuttavia, non sembra così facile, dovendo affrontare un ostacolo: il paradosso di Moravec. Secondo questo paradosso, che si staglia all’interfaccia tra robotica e IA, il ragionamento di alto livello che sottende le nostre attività mentali richiederebbe pochissimo calcolo. Al contrario, implementare le capacità sensoriomotorie richiederebbe quantità di calcolo spropositate. Secondo lo stesso Hans Moravec, che definì il paradosso, ciò è dovuto al fatto che le porzioni di cervello animale dedicate alle abilità sensoriali e motorie sono costruite su centinaia di milioni di anni di interazioni con il mondo, mentre le abilità mentali di alto livello sono un’innovazione relativamente recente, per cui molto più semplici e quindi replicabili in una macchina.

“Ti interessa?” Tale domanda, a prima vista fuori posto, invero evidenzia un altro grande scarto tra l’uomo e le IAqG. Dicevamo che il sogno di una IAqG è diventare del tutto generale per poter disporre di una cognizione simil-umana. Questo le consentirebbe di fare scelte, elaborare ipotesi, e una miriade di altre operazioni, incluso, perché no, fare scienza, filosofia, letteratura o geopolitica. Ciò delegherebbe la guida dei popoli o la creazione di conoscenza, perciò la creazione delle nostre verità, a una macchina, scalzando l’uomo.

Allora, dobbiamo temere le IA? Detenendo la generazione di verità e perfezionatesi nel tempo, potrebbero esse trasformarsi nel nostro nuovo Dio? Per rispondere a ciò, proviamo a osservarci. Se guardiamo a noi e agli altri esseri viventi come a esempi di chi sa stare al mondo, ci accorgiamo che tutti possediamo una storia. È durante tale storia che formiamo le nostre abilità di ragionare scaltramente o di muoverci in maniera acrobatica. In principio, ciò potrebbe farlo anche una macchina. Tuttavia, c’è un altro aspetto importante: la nostra storia ci dota anche dei nostri stessi difetti, temperamenti, sensibilità, credenze, che ci faranno poi provare piacere e dispiacere, amori e dolori, etc. Cioè, noi abbiamo una storia, mentre la macchina ne ha tante quanti sono i dati, ma nessuna è sua. Sarà possibile programmare tali aspetti in una macchina? Per ora, questa squisita irrazionalità ci ha fatto stare al mondo e compiere scelte. Per esempio, i nostri gusti potrebbero spingerci a studiare qualcosa e ad ignorare altro, dirigendo così le nostre conoscenze future. In altre parole, ciò ci consente qualcosa che una macchina ancora non può, come il rispondere a domande del tipo “ti interessa?”.

Questo articolo è pubblicato anche sul numero di Luglio/Settembre di eastwest

Puoi acquistare la rivista sul sito o abbonarti